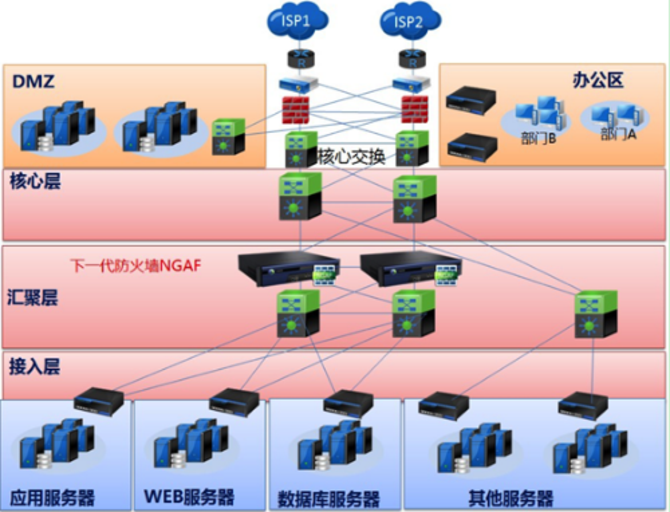

傳統數據中心主要按功能定義,如WEB、APP、DB、辦公區、業務區、內聯區、外聯區等,不同區域之間通過網段和安全設備進行通信,保證可靠性和安全性不同地區的。 同時,由于不同區域的功能不同,當需要相互訪問數據時,只有終端之間可以通信,并不一定要求通信雙方在同一VLAN或二層網絡。

在傳統的數據中心網絡技術中,STP是二層網絡中極其重要的契約。 用戶在構建網絡時,為了保證可靠性,一般會采用冗余設備和冗余鏈路,這就不可避免地會產生分支。 另一方面,二層網絡處于同一個廣播域,廣播報文會在分支機構反復、連續傳輸,產生廣播風暴,立即造成端口擁塞和設備癱瘓。 為此,為了避免廣播風暴,需要避免產生分支。 這樣,為了避免分支,保證可靠性復制物理網絡連接狀態,只能將冗余設備和冗余鏈路做成備份設備和備份鏈路。 即冗余設備端口和鏈路在正常情況下被阻塞,不參與數據包的轉發。 只有當當前轉發設備、端口或鏈路發生故障,導致網絡故障時,冗余設備端口和鏈路才會打開,網絡才能恢復正常。 實現這種人工控制功能的是STP(Tree, tree )。

由于STP的收斂性能和其他激勵因素,通常STP網絡規模不會超過100臺交換機。 同時,由于STP需要阻塞冗余設備和鏈路,也提高了網絡資源的帶寬利用率。 因此,在實際網絡規劃中,考慮轉發性能、利用率、可靠性等,會盡可能控制STP網絡范圍。

二樓也是流通需求

隨著數據集中化的發展和虛擬化技術的應用,數據中心的規模日益擴大。 除了對二層網絡區域范圍的要求越來越高,在要求和管理水平上也提出了新的挑戰。

隨著數據中心區域規模和業務處理需求的縮小,集群處理應用越來越多,集群中的服務器必須在二層VLAN下。 同時,基于虛擬化技術應用帶來的業務部署的便捷性和靈活性,虛擬機的遷移也成為了必須考慮的問題。 為保證虛擬機承載業務的連續性,遷移前后虛擬機的IP地址保持不變,因此虛擬機的遷移范圍必須在同一個二層VLAN內。

反之,二層網絡的大小和虛擬機可以遷移多遠。

傳統的基于STP的備份設備和鏈路方案早已無法滿足數據中心的規模和帶寬需求,而STP合約幾秒到幾分鐘的故障收斂時間也無法滿足數據中心的可靠性要求。 為此,需要新技術。 在滿足二層網絡規模的同時,充分利用冗余設備和鏈路,提高鏈路利用率,將數據中心的故障收斂時間提升至亞秒級甚至微秒級。

二樓需要多大

既然要擴展二層網絡的規模,那么多大合適呢? 這取決于應用場景和技術選擇。

1.在數據中心

第二層首先要解決的是數據中心內部的網絡擴容問題。 通過大規模二層網絡和VLAN的擴展,可以實現數據中心虛擬機的大規模遷移。 由于數據中心的大二層網絡必須覆蓋多臺接入交換機和核心交換機,主要有以下兩類技術。

虛擬交換機技術

虛擬交換機技術的出發點很簡單,屬于工科。 由于二層網絡的核心是分支問題,而分支問題是由冗余的設備和鏈路組成的,所以如果將兩個或多個設備和兩個或多個相互冗余的鏈路組合起來一次設備和一條鏈路形成了,就可以回到之前的單機單鏈路的情況,分支自然就不存在了。 特別是隨著交換機技術的發展,虛擬交換機從高端的盒式設備到高端的框式設備都得到了廣泛的應用復制物理網絡連接狀態,并取得了相當的成熟度和穩定性。 因此,虛擬交換機技術成為應用最為廣泛的大規模二層解決方案。

虛擬交換機技術的代表有H3C的IRF和Cisco的VSS,其特點是只需交換機軟件升級即可支持,應用成本低,部署簡單。 目前該技術由各廠商獨立實現和完成,虛擬化只能在同一廠商的同系列產品之間實現。 同時,由于高端模塊化交換機的性能和密度越來越高,對虛擬交換機的技術要求也越來越高。 目前模塊化交換機的虛擬化密度高達4:1。 虛擬交換機的密度限制了網絡的規模,大約有 10,000 到 20,000 臺服務器。

隧道技術

隧道技術屬于技術派,出發點是借船出海。 二層網絡不能有分支,必須阻塞冗余鏈路,但是三層網絡好像沒有這個問題,ECMP(等效鏈路)也可以,能借用嗎?

通過在二層報文前插入一個額外的幀頭,但是使用路由估計的方法來控制全網數據的轉發,另外還可以避免冗余鏈路下的廣播風暴,做ECMP。 這樣可以使二層網絡的規模可以擴展到整個網絡,而不受核心交換機數量的限制。

隧道技術的代表是TRILL和SPB,它們都是利用IS-IS路由契約的估計和轉發方式來實現二層網絡的大規模擴展。 該技術的特點是可以構建比虛擬交換機技術更大的超大規模二層網絡(應用于大規模集群估計),但尚未完全成熟,目前正在標準化中. 同時,傳統交換機除了軟件升級外,還需要硬件支持。

2.跨數據中心

隨著數據中心多中心部署、虛擬機跨數據中心遷移、容災、跨數據中心業務負載分擔,二層網絡的擴展必須考慮超出數據中心邊界. 數據中心機房面積延伸至同城備份中心和異地容災中心。

通常,多個數據中心之間的連接都是通過路由連接起來的,自然是三層網絡。 為了實現通過三層網絡連接的兩個二層網絡之間的互通,必須實現“”。

L2oL3技術也有很多,比如傳統的VPLS()技術,以及新興的Cisco OTV和技術,都是采用隧道的形式,將二層數據包封裝在三層數據包中,跨越中間三層網路,實現兩地二層數據互通。 這些隧道就像一座虛擬的橋梁,將多個數據中心的二層網絡連接在一起。

此外,一些虛擬化和軟件廠商提出了軟件技術方案。 如VXLAN和微軟的NVGRE,在虛擬化層,將第二層數據封裝在UDP和GRE包中,在化學網絡拓撲上建立一層虛擬化網絡層,從而擺脫網絡設備層。 二樓和三樓是有限制的。

由于性能、可擴展性等問題,該技術并未得到廣泛應用。

數據中心互聯方式

網絡三層互聯。 稱為數據中心后端網絡互連,所謂“后端網絡”是指數據中心出口到企業園區網或企業廣域網。 不同數據中心(主中心、災備中心)的后端網絡通過IP技術互聯,園區或分支機構的客戶通過后端網絡訪問各個數據中心。 當主數據中心發生災難時,后端網絡將實現快速收斂,客戶端可通過接入容災中心保障業務連續性;

第 2 層互連。 稱之為數據中心服務器網絡互聯。 在不同數據中心的服務器網絡接入層,建立跨數據中心的大二層網絡(VLAN),滿足二層網絡接入等場景的服務器集群或虛擬機動態遷移需求;

SAN互連。

稱之為前端存儲網絡互聯。 利用傳輸技術(DWDM、SDH等)實現主中心與災備中心之間C盤陣列的數據復制。

數據中心二層互聯業務需求

服務器高可用性集群

服務器集群()是利用集群軟件將網絡上的多臺服務器關聯在一起,提供一致的服務,對外表現為一個邏輯服務器。 大多數廠商(HP、IBM、微軟等)的集群軟件都需要使用二層網絡來實現服務器之間的互聯。 將集群中的服務器部署在不同的數據中心,可以實現應用系統跨數據中心的容災。

服務器搬遷和虛擬機熱遷移

當數據中心改造或搬遷時,化學服務器需要從一個數據中心移動到另一個數據中心。

在此過程中,考慮到以下兩方面的動因,需要在數據中心之間建立二層互連網絡:

當服務器搬遷到新機房時,如果新舊中心之間的二層網絡還沒有搭建好,將面臨重新規劃新中心服務器IP地址的問題,并且在同時,需要更改DNS或更改客戶端應用程序配置的服務器IP。 因此,建立跨中心的二層互聯網,可以保留被遷移服務器的IP地址,從而簡化遷移過程;

在服務器搬遷過程中,往往只能在給定的時間段內將服務器組中的一部分服務器遷移到新的中心。 為了保證業務的連續性,需要完善跨中心的服務器集群,建立跨中心的二層互聯網網絡,才能實現服務器的平滑遷移。

與服務器搬遷類似的一種情況是“虛擬機遷移”。 目前,一些服務器虛擬化軟件可以實現虛擬機在兩臺虛擬化化工服務器之間的動態遷移。 遷移到另一個中心的虛擬機不僅保留了原來的IP地址,還保持遷移前的運行狀態(如TCP會話狀態),所以虛擬機遷移涉及的化學服務器必須連接到同一個二層網絡(虛擬機遷移前后網段不變),這些應用場景都需要建立跨中心的二層互聯網絡。

數據中心二層互連設計要點

1. 前提要素——現網狀態

選擇數據中心二層互聯方案的前提是明確用戶在多個數據中心之間擁有哪些網絡資源。 網絡資源的差異直接決定了用戶會采用哪種組網方案:

運營商、大型互聯網公司:裸纖或DWDM傳輸資源,對應RRPP環網方案或HUB-SPOKE方案;

運營商、大型企業、金融、政府機構:MPLS網絡,對應VPLS組網方案;

中小企業客戶:IP網絡,對應組網方案

2. 核心要素——性能

信噪比

數據中心之間的二層互聯是實現虛擬機異地調度和異地集群應用。 為此,必須滿足虛擬機和集群存儲異地訪問的信噪比要求。 第一個限制是同步會話距離。 第二個要求是存儲網絡。 數據中心之間的存儲必須實現同步訪問或鏡像訪問。

需要注意的是,在VPLS或IP網絡環境中,由于網絡中存在大量復雜的應用,需要部署全網QoS來保證DCI互聯數據流的服務質量。 流量環境越復雜,QoS配置的工作量越大,信噪比指標越不理想。 VPLS網絡一般用于企業或行業的私有業務。 與IP網絡相比,流量環境更為簡單,因此在部署QoS方面具有一定的優勢。

帶寬

數據中心互聯的核心需求之一是保證虛擬機跨數據中心的遷移。 .0之前的版本對遷移鏈路的帶寬有明確要求——帶寬不大于622M; .0版本,遷移鏈路帶寬不大于250M。

從帶寬資源分配來看,裸纖或DWDM帶寬資源最為充足,而VPLS和IP網絡帶寬資源相對緊張。 全網部署端到端的QoS優先級,保證DCI業務流量的帶寬需求。

3. 關鍵要素 - 醫管局

數據中心二層互聯的關鍵是如何提高可用性。 提高HA最有效的方法之一是設計備份鏈路和備份節點。 如果結合需要增加互聯帶寬,建議設計負載分擔的互聯路徑。 在增加互聯帶寬的同時,也可以保證系統出現異常時業務能夠快速收斂,提高HA指標。

以DWDM網絡為例,推薦使用IRF實現DCI鏈路的高HA和鏈路負載分擔設計方案。

在裸纖或DWDM互連組網方案中,DCI互連兩端的PE設備必須支持IRF,PE之間的兩條(或多條)鏈路聚合(LACP)生成一條邏輯鏈路。 極大地簡化了 DCI 網絡拓撲。 同時,兩條HA鏈路的帶寬將得到100%的利用,達到1:1的負載分擔效果。

數據中心二層互聯方案設計

1、基于裸纖或DWDM線路的二層互聯

裸纖或DWDM二層互連方案,要求用戶在現網有光纖或傳輸資源,對用戶要求高。 但從使用的角度來看,裸纖或DWDM方案的性能是最優的。

基于裸纖或DWDM線路的二層互連方案有兩種選擇:HUB-SPOKE方案和RRPP環網方案。 后者的優點是基于最短路徑轉發,轉發效率高; 前者的優點是環網的自然轉發路徑冗余設計,因此HA性能高。

中心輻射型網絡解決方案

多個(例如4個)數據中心通過裸纖或DWDM互連。 為了方便擴展更多的數據中心節點,一種最常見的解決方案是采用HUB-SPOKE組網模型,即通過一個核心節點與各個數據中心的凝聚層互連。 在邏輯結構上,多個中心和核心節點組成了一個Hub-Spoke星型拓撲結構,其中核心節點是HUB,每個中心的內聚層是Spoke。

在Hub-Spoke組網環境中,核心節點最為重要,關系到整個網絡的正常運行,是保證多數據中心HA的關鍵因素。 如何提高核心節點的HA性能? 最重要的設計理念之一是將IRF技術應用到核心節點上,通過IRF技術將兩臺設備生成一臺設備,將核心設備故障異常的收斂時間從幾十秒提高到納秒級,也就是說,系統的HA性能可以提高近兩個數量級。 這對于 Hub-Spoke 網絡解決方案非常重要。

1億人在購物,1%在學習! 很多人都準備省下幾十塊錢,卻忘了擁有更好的薪水才能為自己和家人創造更好的生活! 快來學習:SPOTO給你雙12三倍好禮,申請思科/華為精品課程最高立減11000! 思維的廣度決定生活的質量,點擊鏈接有獎:!

為了方便廣大愛好網絡的學習者,在QQ群上傳了一個QQ群——思科華為數據庫第二群(一組已滿),上傳了大量網絡學習資料. 歡迎網絡工程師進群學習!